Robots.txt

File robots.txt đóng vai trò như một "người gác cổng" quan trọng, kiểm soát cách các công cụ tìm kiếm truy cập và thu thập dữ liệu từ trang web của bạn. Việc hiểu rõ và cấu hình đúng file này có thể tạo ra sự khác biệt lớn trong hiệu suất SEO của website.

Robots.txt Là Gì?

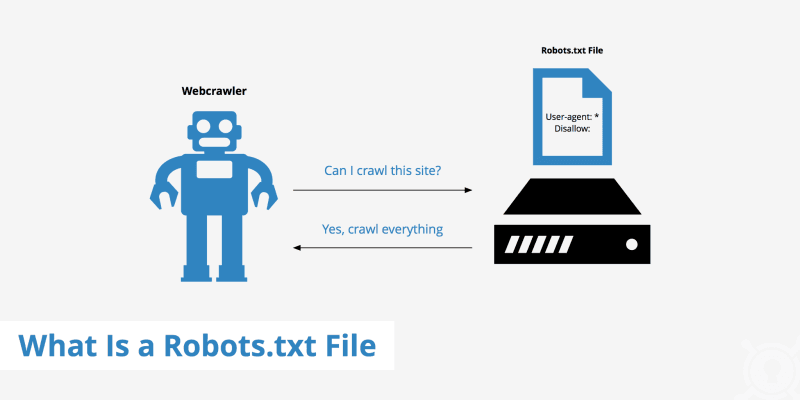

Robots.txt là một file văn bản đơn giản được đặt ở thư mục gốc của website, tuân theo chuẩn Robots Exclusion Protocol. File này chứa các chỉ thị hướng dẫn các bot của công cụ tìm kiếm (như Googlebot, Bingbot) về những phần nào của website được phép hoặc không được phép truy cập và thu thập dữ liệu.

Khi một bot truy cập website, điều đầu tiên nó làm là kiểm tra file robots.txt tại địa chỉ yourdomain.com/robots.txt. Dựa trên các quy tắc trong file này, bot sẽ quyết định crawl những trang nào và bỏ qua những trang nào.

Cấu Trúc và Cú Pháp Cơ Bản

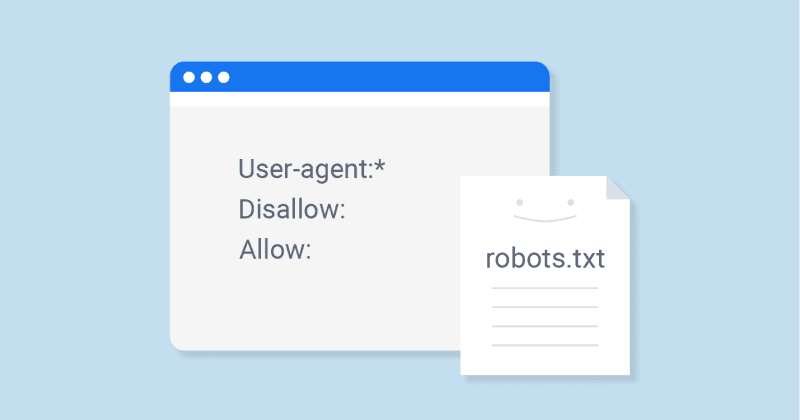

File robots.txt sử dụng cú pháp đơn giản với các thành phần chính:

- User-agent: Xác định bot cụ thể mà quy tắc áp dụng. Ví dụ: "User-agent: Googlebot" hoặc "User-agent: *" (áp dụng cho tất cả bot).

- Disallow: Chỉ định đường dẫn không cho phép bot truy cập. Ví dụ: "Disallow: /admin/" sẽ chặn truy cập vào thư mục admin.

- Allow: Cho phép truy cập vào một đường dẫn cụ thể, thường dùng để ghi đè lệnh Disallow rộng hơn.

- Sitemap: Chỉ định vị trí file sitemap XML giúp bot tìm thấy và thu thập nội dung hiệu quả hơn.

Một ví dụ cơ bản: User-agent: * / Disallow: /wp-admin/ / Allow: /wp-admin/admin-ajax.php / Sitemap: https://yourdomain.com/sitemap.xml

Tại Sao Robots.txt Quan Trọng Với SEO?

Quản lý Crawl Budget: Các công cụ tìm kiếm có giới hạn về số lượng trang họ có thể crawl trên website của bạn trong một khoảng thời gian. Robots.txt giúp bạn hướng bot đến những trang quan trọng nhất, tránh lãng phí crawl budget vào các trang không cần thiết như trang quản trị, trang cảm ơn, hoặc các file hệ thống.

Bảo vệ nội dung nhạy cảm: Mặc dù robots.txt không phải là biện pháp bảo mật thực sự, nó giúp ngăn các trang nội bộ, trang đang phát triển, hoặc nội dung trùng lặp xuất hiện trên kết quả tìm kiếm.

Tối ưu hiệu suất indexing: Bằng cách chặn các file CSS, JavaScript không quan trọng hoặc các thư mục tạm thời, bạn giúp bot tập trung vào việc index nội dung chính của website.

Những Lỗi Phổ Biến Cần Tránh

Nhiều quản trị viên website mắc phải những sai lầm nghiêm trọng khi cấu hình robots.txt. Lỗi phổ biến nhất là vô tình chặn toàn bộ website bằng lệnh "Disallow: /" dưới "User-agent: *", khiến website biến mất khỏi kết quả tìm kiếm.

Một lỗi khác là chặn các file CSS và JavaScript quan trọng. Google cần truy cập những file này để hiểu cách website hiển thị và đánh giá trải nghiệm người dùng. Việc chặn chúng có thể ảnh hưởng tiêu cực đến ranking.

Cần nhớ rằng robots.txt không phải là công cụ bảo mật. Các URL bị chặn trong robots.txt vẫn có thể xuất hiện trong kết quả tìm kiếm nếu có liên kết từ website khác trỏ đến. Để bảo vệ nội dung thực sự, hãy sử dụng mật khẩu, robots meta tag "noindex", hoặc các biện pháp bảo mật khác.

Cách Tạo và Kiểm Tra Robots.txt

Tạo file robots.txt rất đơn giản. Sử dụng trình soạn thảo văn bản thuần túy (như Notepad), viết các quy tắc cần thiết, lưu với tên "robots.txt" và upload lên thư mục gốc của website.

Sau khi tạo, bạn nên kiểm tra kỹ lưỡng. Google Search Console cung cấp công cụ "robots.txt Tester" cho phép bạn kiểm tra cú pháp và xem bot Google có thể truy cập các URL cụ thể hay không. Công cụ này cực kỳ hữu ích để phát hiện lỗi trước khi chúng ảnh hưởng đến SEO.

Tóm lại, robots.txt là công cụ không thể thiếu trong bộ công cụ SEO của mọi webmaster. Khi được cấu hình đúng cách, nó giúp tối ưu hóa cách công cụ tìm kiếm tương tác với website, bảo vệ nội dung nhạy cảm và cải thiện hiệu suất SEO tổng thể. Hãy dành thời gian để hiểu và triển khai file robots.txt phù hợp cho website của bạn.

Có thể Bạn quan tâm ?

![[THÔNG BÁO] LỊCH NGHỈ TẾT NGUYÊN ĐÁN BÍNH NGỌ 2026](https://seovip.vn/wp-content/uploads/2026/02/thong-bao-nghi-tet-70x50.jpg)

![[Tổng kết] Sự kiện Martech Đà Nẵng 2026: Chiến lược “Nuôi Team – Đi Đường Dài”](https://seovip.vn/wp-content/uploads/2026/01/tong-ket-su-kien-martech-da-nang-2026-11-70x50.png)